電商高并發(fā)系統(tǒng)架構(gòu)實戰(zhàn) 從商品詳情頁到預約搶購的百萬級流量解決方案

隨著電子商務的蓬勃發(fā)展,日均百萬流量的電商平臺已成為行業(yè)常態(tài)。面對海量用戶的瞬時訪問與高并發(fā)交易請求,構(gòu)建一個穩(wěn)定、高性能、可擴展的系統(tǒng)架構(gòu)至關重要。本文將以一個百萬流量電商網(wǎng)站為例,系統(tǒng)闡述商品詳情頁系統(tǒng)架構(gòu)的整體設計思路,并重點剖析基于Redis的高并發(fā)預約搶購系統(tǒng)與信息系統(tǒng)集成服務的核心實現(xiàn)方案。

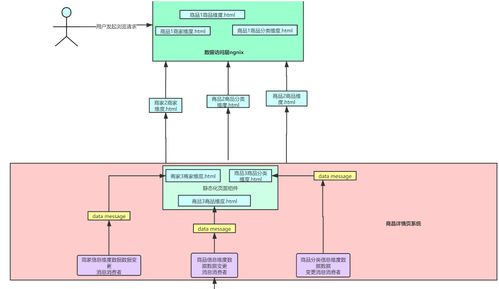

一、商品詳情頁系統(tǒng)架構(gòu)的整體設計

商品詳情頁作為用戶決策的核心入口,其性能與穩(wěn)定性直接影響轉(zhuǎn)化率。一個成熟的高流量詳情頁架構(gòu)通常采用分層、解耦與異步化的設計理念。

- 前端架構(gòu):

- 動靜分離:將商品圖片、描述詳情等靜態(tài)資源推送到CDN,利用邊緣節(jié)點加速全球訪問。

- 頁面靜態(tài)化:對不頻繁變化的商品信息(如品牌、分類、基礎屬性)進行靜態(tài)化生成,直接返回HTML,極大減輕后端壓力。對于價格、庫存等動態(tài)信息,通過Ajax異步加載。

- 客戶端緩存:合理利用瀏覽器本地緩存(LocalStorage)和HTTP緩存策略,減少重復請求。

- 后端服務層:

- 微服務拆分:將商品服務、庫存服務、價格服務、營銷服務(優(yōu)惠券、促銷)等拆分為獨立的微服務,實現(xiàn)業(yè)務解耦與獨立擴縮容。

- 應用級緩存:在服務層引入本地緩存(如Caffeine、Guava Cache),緩存熱點商品數(shù)據(jù),響應時間可降至毫秒級。

- 服務聚合與降級:通過API網(wǎng)關或BFF(Backend For Frontend)層聚合多個下游服務的返回數(shù)據(jù)。針對非核心服務(如商品評價、推薦)設置服務降級策略,保證核心鏈路(商品、價格、庫存)的高可用。

- 數(shù)據(jù)層與緩存策略:

- 多級緩存體系:構(gòu)建“客戶端緩存 → CDN → 反向代理緩存(如Nginx)→ 應用本地緩存 → 分布式緩存(Redis)”的多級緩存屏障。絕大部分請求在到達數(shù)據(jù)庫前已被攔截。

- 數(shù)據(jù)庫優(yōu)化:

- 讀寫分離:主庫負責寫操作,多個從庫承擔讀請求,分攤壓力。

- 分庫分表:根據(jù)商品ID或店鋪ID對商品庫進行水平拆分,解決單表數(shù)據(jù)量過大問題。

- 熱點數(shù)據(jù)識別:通過實時監(jiān)控,將“爆款”商品數(shù)據(jù)在Redis中進行預熱。

二、基于Redis的高并發(fā)預約搶購系統(tǒng)設計

預約搶購場景(如秒殺、新品首發(fā))是典型的高并發(fā)、高一致性挑戰(zhàn)。Redis憑借其單線程內(nèi)存操作、豐富數(shù)據(jù)結(jié)構(gòu)及原子命令,成為該場景的核心組件。

- 流量削峰與分層過濾:

- 預約階段:用戶提前預約,系統(tǒng)記錄用戶與商品關系。此階段可進行資格預校驗(如賬號狀態(tài)、收貨地址完善度),并預估參與人數(shù),為資源準備提供數(shù)據(jù)支撐。

- 活動預熱:將商品庫存提前加載至Redis,使用

String或Hash結(jié)構(gòu)存儲。關鍵數(shù)據(jù)如seckill:stock:{skuId}。

- 秒殺開始:

- 絕大部分請求在網(wǎng)關層通過令牌桶或漏桶算法進行限流,僅放行少量請求至后端。

- 用戶點擊“搶購”后,首先進行風控校驗(如防刷、黑名單),然后進入核心庫存扣減流程。

2. 核心庫存扣減方案:

* 原子操作保證一致性:使用Redis的原子命令(如DECR、INCR)或Lua腳本來扣減庫存。這是最關鍵的步驟,確保在高并發(fā)下不會超賣。

`lua

-- 示例Lua腳本:扣減庫存,庫存不足時返回0

local stock = redis.call('get', KEYS[1])

if (not stock) or tonumber(stock) <= 0 then

return 0

end

if tonumber(stock) >= tonumber(ARGV[1]) then

redis.call('decrby', KEYS[1], ARGV[1])

return 1

end

return 0

`

- 請求隊列化:成功扣減Redis庫存的請求,并不直接操作數(shù)據(jù)庫,而是將訂單信息(用戶ID、商品ID)推入消息隊列(如RocketMQ、Kafka)。

- 異步下單與最終一致性:下游的訂單服務從隊列中消費消息,進行更復雜的業(yè)務校驗(如重復購買)、生成訂單、扣減數(shù)據(jù)庫庫存。通過此方式,將瞬間的同步寫壓力轉(zhuǎn)化為異步的平穩(wěn)消費,保護數(shù)據(jù)庫。

- 防刷與公平性保障:

- 用戶維度限流:使用Redis的

SETNX命令或令牌機制,限制單一用戶在規(guī)定時間內(nèi)的請求次數(shù)。

- 庫存預熱與隨機化:可考慮將部分庫存分配至不同Redis節(jié)點或鍵中,分散熱點。

- 結(jié)果異步返回:搶購請求立即返回“排隊中”狀態(tài),用戶通過輪詢或WebSocket/Push方式獲取最終結(jié)果(成功/失敗)。

三、信息系統(tǒng)集成服務設計

在復雜的電商系統(tǒng)中,訂單、支付、物流、倉儲、客服等系統(tǒng)需要高效協(xié)同。集成服務作為“中樞神經(jīng)”,負責系統(tǒng)間的數(shù)據(jù)交換與流程編排。

- 集成模式選擇:

- 面向消息的中間件(MOM):核心業(yè)務事件(如“訂單已創(chuàng)建”、“支付已成功”)通過消息隊列發(fā)布,各訂閱系統(tǒng)異步消費,實現(xiàn)系統(tǒng)解耦與最終一致性。這是高并發(fā)場景下的首選。

- API網(wǎng)關集成:對外部合作伙伴(如第三方物流、支付渠道)提供統(tǒng)一、安全的API入口,集成認證、限流、監(jiān)控、路由等功能。

- 企業(yè)服務總線(ESB):在傳統(tǒng)大型企業(yè)中,可能采用ESB進行協(xié)議轉(zhuǎn)換、消息路由和集中管理。

- 數(shù)據(jù)一致性保障:

- 分布式事務:對于強一致性場景(如扣庫存同時生成訂單),可采用TCC(Try-Confirm-Cancel)、Saga等分布式事務方案,或依賴消息隊列的“本地事務表+定時任務”方案確保數(shù)據(jù)最終一致。

- 數(shù)據(jù)同步:利用Canal等工具監(jiān)聽數(shù)據(jù)庫Binlog,將變更數(shù)據(jù)實時同步到搜索索引(如Elasticsearch)、數(shù)倉或緩存,解決多數(shù)據(jù)源的一致性問題。

- 可觀測性與治理:

- 全鏈路追蹤:集成SkyWalking、Jaeger等工具,為每個請求分配唯一ID,追蹤其在各微服務間的流轉(zhuǎn)路徑,便于故障定位與性能分析。

- 統(tǒng)一監(jiān)控告警:對集成接口的調(diào)用量、響應時間、錯誤率進行集中監(jiān)控,并設置閾值告警。

- 配置中心:使用Nacos、Apollo等管理所有系統(tǒng)的配置信息,實現(xiàn)動態(tài)刷新,避免因配置變更導致的系統(tǒng)重啟。

###

構(gòu)建百萬流量電商系統(tǒng)是一項系統(tǒng)性工程。商品詳情頁架構(gòu)的核心在于通過多級緩存與動靜分離抵御讀高峰;預約搶購系統(tǒng)的關鍵在于利用Redis的原子性實現(xiàn)庫存精準扣減,并通過消息隊列異步化實現(xiàn)寫請求的削峰填谷;而信息系統(tǒng)集成服務則像粘合劑,通過異步消息與標準化接口,確保各子系統(tǒng)在解耦的前提下高效協(xié)同。這三者有機結(jié)合,共同構(gòu)成了一個能夠應對海量并發(fā)、保障數(shù)據(jù)一致、且易于擴展的現(xiàn)代電商平臺技術底座。在實際實施中,還需結(jié)合具體業(yè)務特點、團隊技術棧和成本預算,進行持續(xù)的迭代與優(yōu)化。

如若轉(zhuǎn)載,請注明出處:http://www.skycatch.cn/product/26.html

更新時間:2026-01-21 10:32:58